O YouTube, uma das plataformas mais populares para compartilhamento de vídeos, recentemente anunciou medidas para combater a disseminação de “desinformação” e “deepfakes”. De acordo com a plataforma, essas ações representariam um passo significativo em direção à proteção dos usuários contra conteúdo enganoso e potencialmente prejudicial.

A palavra “deepfake” deriva da junção de “deep learning” (aprendizado profundo) e “fake” (falso), o que destaca a capacidade da inteligência artificial em produzir conteúdo enganoso. Esta técnica é capaz de alterar o rosto de uma pessoa em um vídeo existente ou mesmo criar vídeos completamente fictícios, nos quais pessoas realizam ações ou dizem coisas que nunca ocorreram na realidade. Vale ressaltar que a “IA” nada produz sozinha, pelo menos por enquanto; ela depende das instruções de um humano para entregar os resultados.

Os alertas começarão nas próximas semanas, inicialmente nos aplicativos para celular, e posteriormente serão estendidos para computadores e TVs. Essa medida visa notificar os usuários sempre que o conteúdo identificado tiver a produção toda ou em parte feita por IA.

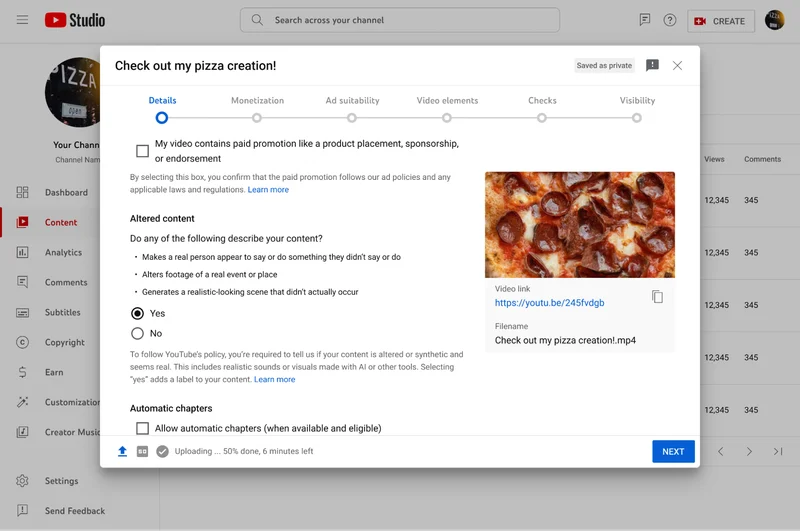

As perguntas feitas são:

- Coloca uma pessoa real aparentemente fazendo ou dizendo algo que ela não fez ou disse?

- Altera gravações de eventos ou lugares reais?

- Gera uma cena que parece realística, mas que não aconteceu de verdade?

O YouTube diz que reconhece o potencial do uso indevido de inteligência artificial para criar deepfakes e espalhar desinformação. Com o avanço da tecnologia, tornou-se cada vez mais fácil manipular vídeos de forma convincente, levantando sérias preocupações sobre a autenticidade do conteúdo disponível online. A disseminação de vídeos e fotos manipuladas por Inteligência Artificial pode comprometer a confiança dos usuários e minar a integridade da plataforma como um todo.

Em resposta a essa ameaça, o YouTube implementou medidas proativas para identificar e rotular vídeos que supostamente contenham elementos realistas de IA. Uma das principais iniciativas é a identificação obrigatória de vídeos modificados por inteligência artificial. Os criadores de conteúdo agora são obrigados a declarar se um vídeo foi alterado por IA, o que permitiria uma maior transparência sobre a origem do conteúdo.

Além disso, o YouTube também introduziu rótulos de aviso em vídeos com elementos realistas gerados por IA. Esses avisos visam alertar os usuários sobre a possibilidade de manipulação do conteúdo e incentivá-los a adotar uma abordagem mais crítica ao consumir informações online.

A OpenAI, responsável pelo desenvolvimento do ChatGPT, também está comprometida em evitar o uso de sua tecnologia na criação de fake news. Ela tem uma parceria com o Youtube para moderar os vídeos da plataforma.

Segundo o Youtube, o objetivo principal dessas medidas é proteger os usuários contra a desinformação e os deepfakes, fortalecendo assim a confiabilidade do conteúdo disponível na plataforma. Ao aumentar uma suposta transparência e fornecer avisos sobre vídeos potencialmente manipulados, o YouTube argumenta que pode criar um ambiente online mais seguro e confiável para todos os usuários da plataforma.

Embora as iniciativas implementadas pelo YouTube para combater a desinformação e os deepfakes sejam louváveis em sua intenção de proteger os usuários e promover um ambiente online mais seguro, é importante considerar os riscos associados a essas medidas.

Uma das principais preocupações é o potencial de censura e restrição à liberdade de expressão. Ao rotular vídeos como potencialmente manipulados por inteligência artificial, há o risco de que conteúdos legítimos sejam erroneamente marcados e, consequentemente, excluídos ou desconsiderados pelos usuários. Isso pode levar a uma diminuição da diversidade de opiniões e perspectivas na plataforma, comprometendo assim a liberdade de expressão e o debate saudável.

As medidas adotadas pelo YouTube e outras plataformas podem não ser totalmente eficazes na detecção e remoção de conteúdos enganosos. Deepfakes e outras formas avançadas de manipulação de mídia estão em constante evolução, e os algoritmos de detecção podem não ser capazes de acompanhar essa rápida mudança. Isso significa que mesmo sem os rótulos de aviso, os usuários ainda podem ser enganados por conteúdos falsos e prejudiciais de vídeos ou áudios criminosos.

Outra preocupação é o possível uso indevido dessas medidas para manipular a opinião pública e influenciar eventos importantes, como eleições. A identificação e rotulagem de vídeos modificados por IA podem ser exploradas por indivíduos ou grupos com interesses políticos ou ideológicos específicos para desacreditar opositores ou promover agendas próprias.

Portanto, enquanto é importante combater a disseminação de desinformação e proteger os usuários contra os riscos associados aos deepfakes, é crucial garantir que as medidas adotadas não comprometam a liberdade de expressão, a diversidade de opiniões e a integridade do processo democrático.